Inteligência Artificial já é capaz de clonar a personalidade de qualquer pessoa

Pesquisadores desenvolvem modelo que consegue replicar o caráter de um indivíduo com base em entrevista de duas horas, em avanço que traz benefícios – e riscos

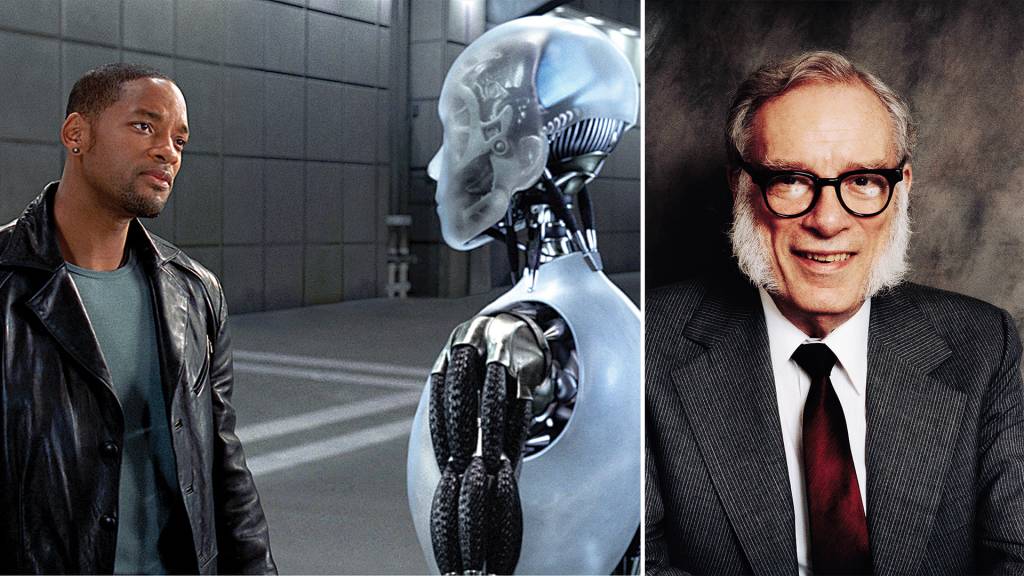

Introduzidas na coletânea de contos Eu, Robô, de 1950, as leis da robótica formuladas pelo escritor Isaac Asimov (1920-1992) são um conjunto de diretrizes para regular o comportamento de androides e garantir a segurança dos seres humanos em suas interações com máquinas inteligentes. Elas regem a totalidade das histórias contidas no volume, quase sempre em um futuro no qual as figuras sintéticas seriam uma realidade corriqueira. A primeira e seminal regra — “um robô não pode ferir um humano ou, por inação, permitir que um humano sofra algum mal” — é a pedra fundamental de um admirável mundo novo. Na adaptação da antologia para o cinema, em 2004, o detetive Del Spooner desconfia de uma dessas criações, Sonny, como possível assassino de um celebrado cientista. Corte-se para este 2025 que mal começou, e a rápida evolução da inteligência artificial (IA) acende temor semelhante, ou quase.

Uma parceria entre pesquisadores da Universidade Stanford e do Google DeepMind possibilitou a criação de uma modelo capaz de clonar a personalidade de qualquer pessoa. Nem foi preciso, ressalve-se, o desenvolvimento de uma tecnologia revolucionária, nunca vista. Por meio dos recursos do modelo de linguagem por trás do ChatGPT da OpenAI, chatbot mais popular do momento, os especialistas replicaram o caráter, por assim dizer, de mais de 1 000 indivíduos, com base apenas em entrevistas de duas horas. Foi simples: após fazer uma série de perguntas para os entrevistados, sobre infância, memória e carreira, o computador previu o comportamento das pessoas envolvidas no trabalho. Os resultados surpreenderam. Após a interação, a IA conseguiu responder a uma série de questionários de individualidade com uma precisão de 85%. Os duplos, portanto, saíram-se idênticos aos originais. “Já imaginávamos que seria possível clonar personalidades no futuro”, diz Diogo Cortiz, professor da Pontifícia Universidade Católica de São Paulo (PUC-SP). “Mas o artigo mostra que isso acontecerá em breve, com uma abordagem muito simplificada e sem a necessidade de desenvolvimento de tecnologias avançadas.”

Outras ferramentas disponíveis na internet fazem algo semelhante, treinadas com base em e-mails, mensagens de textos e outros arquivos pessoais, criando uma espécie de repositório que se retroalimenta. A nova tecnologia, contudo, vai além — daí o espanto, em passo que nem mesmo Asimov intuiu. Convém ressaltar, contudo, a existência de usos nobilíssimos, no avesso do temor de autônomos descontrolados e irresponsáveis. A imitação de nós, simples mortais, autoriza uma série de experimentos com as máquinas que seriam inviáveis com humanos. Dois exemplos: prever as consequências de uma determinada política pública ou entender um fenômeno social. “Esperamos que esta tecnologia evolua para se tornar uma ferramenta que possibilite estudar fenômenos de sociedade em larga escala”, disse a VEJA Joon Park, pesquisador de doutorado em Stanford e autor do artigo, ainda sem revisão por pares, como manda a norma.

A tecnologia, insista-se, não é perfeita. Por enquanto, a ferramenta só foi testada com um número restrito de avaliações. Não é possível, portanto, saber se ela seria igualmente eficiente em replicar respostas a situações mais complexas ou que saiam do escopo das perguntas realizadas durante a entrevista. De qualquer maneira, o desenvolvimento permite identificar potenciais perigos. Hoje, as ferramentas que grassam por aí já permitem a criação de deepfakes, aqueles áudios e vídeos muito verossímeis, que foram criados digitalmente, sem a utilização de grandes recursos. “Podem ser utilizados para golpes, para a satisfação de um desejo pessoal ou para a manipulação em massa com fins políticos”, diz Cortiz. Além disso, um outro trabalho, liderado por Dongwook Yoon, da Universidade da Colúmbia Britânica, levantou possíveis riscos dos “sujeitos” artificiais, como o medo crescente das máquinas e a dificuldade de criar vínculos, devido à presença disseminada de clones computadorizados. É medo que soa tolo, psicologia de almanaque, mas convém prestar atenção para o que vem por aí.

Não é prudente apenas ignorar os avanços ou proibir o progresso por puro receio. É caminho sem volta, que pressupõe regulação e permanente zelo ético. “É possível minimizar tais riscos por meio de medidas rigorosas, garantindo que os indivíduos estejam totalmente cientes de como seus clones estão sendo usados”, diz Park, de Stanford. É um bom ponto de partida, a largada para um futuro que bate à porta, com gente de carne e osso ainda com as rédeas em mãos, firmes. De Isaac Asimov: “Se o conhecimento pode criar problemas, não é por meio da ignorância que poderemos solucioná-los”. Eis aí um belo lema.

Publicado em VEJA de 3 de janeiro de 2025, edição nº 2925

SEGUIR

SEGUIR

SEGUINDO

SEGUINDO